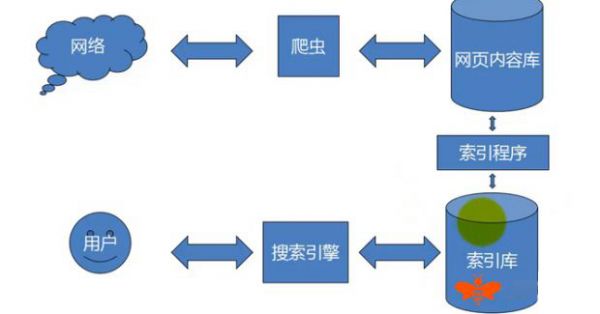

想象一下搜索引擎就像一位不知疲倦的图书馆管理员。这位管理员每天要巡视整个图书馆,记录每本书的位置和内容。搜索引擎爬行就是这样一个持续不断的过程 - 它让搜索引擎能够发现、收集和理解互联网上的海量信息。

1.1 搜索引擎爬行的核心定义解析

搜索引擎爬行本质上是一个自动化的数据收集过程。专业的网络爬虫程序会按照特定规则,系统地浏览互联网上的网页,就像蜘蛛在织网一样不断延伸探索。这个过程不是随意的漫游,而是有目的、有策略的信息采集。

我记得第一次接触这个概念时,把它想象成数字世界的探险家。这些探险家带着明确的任务出发:找到新大陆(新网页),绘制精确地图(网页结构),记录重要地标(关键词和内容)。这种系统性的探索让搜索引擎能够建立庞大的网页索引库。

1.2 网络爬虫(蜘蛛)的基本工作原理

网络爬虫的工作方式其实很精妙。它们从已知的URL种子列表开始访问,读取网页内容的同时,会提取页面中的所有链接。这些新发现的链接会被加入待访问队列,就像探险家发现新路径后标记在地图上等待后续探索。

每个爬虫都遵循着特定的协议和规则。它们会检查robots.txt文件,就像客人进入别人家前先敲门询问是否方便。有些网站可能不希望被索引,爬虫就会尊重这些指示。这种自律性确保了整个爬行过程的文明有序。

1.3 爬行在搜索引擎系统中的定位与作用

在整个搜索引擎的工作流程中,爬行扮演着基础数据采集者的角色。如果把搜索引擎比作一个智能餐厅,那么爬行就是采购食材的环节 - 没有这个步骤,后续的加工和呈现都无法进行。

爬行质量直接影响搜索引擎的表现。优质的爬行能确保索引库的时效性和完整性,让用户搜索时获得最新最相关的结果。这个环节虽然隐藏在后台,却是整个搜索体验的基石。从个人体验来说,每次快速找到需要的信息时,背后都有爬行技术的默默支撑。

如果把互联网比作一个永不停歇的城市,搜索引擎爬行就是那些日夜穿梭的智能快递员。它们知道要去哪里取件,懂得如何高效规划路线,还能根据交通状况调整配送频率。这套精密的运作机制背后,是一系列严谨的技术实现。

2.1 爬行程序的启动与URL发现机制

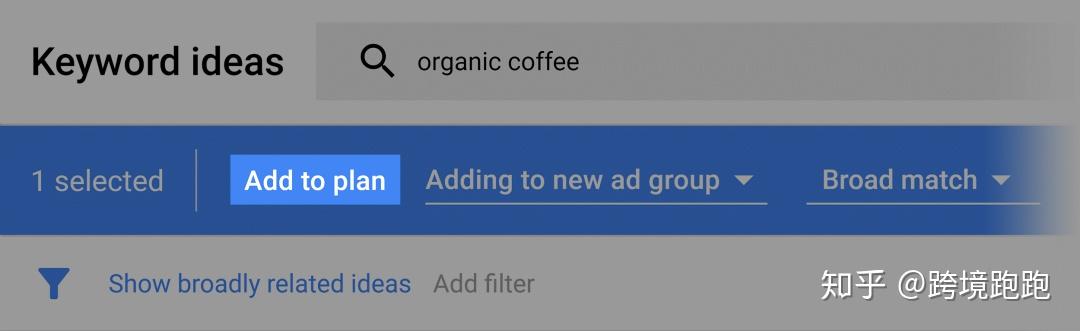

爬行程序通常从一个精心挑选的种子URL集合开始工作。这些种子就像探险家的起点营地,可能是知名门户网站、高质量内容平台或重要新闻站点。程序会优先访问这些“核心区域”,然后顺着链接网络逐步向外扩展。

URL发现过程充满智慧。爬虫在解析每个网页时,会提取所有超链接,就像在迷宫中不断发现新的通道。这些新发现的URL需要经过去重、优先级排序和质量评估。质量较高的网站链接会获得优先访问权,这让我想起曾经观察过一个新闻网站的收录过程 - 重要新闻页面往往在发布后几分钟内就被抓取,而边缘页面可能需要等待数天。

发现新URL的途径其实很丰富。除了常规的链接追踪,搜索引擎还会参考历史数据、网站地图、甚至其他渠道提交的URL。这种多渠道的发现机制确保了爬行的全面性。

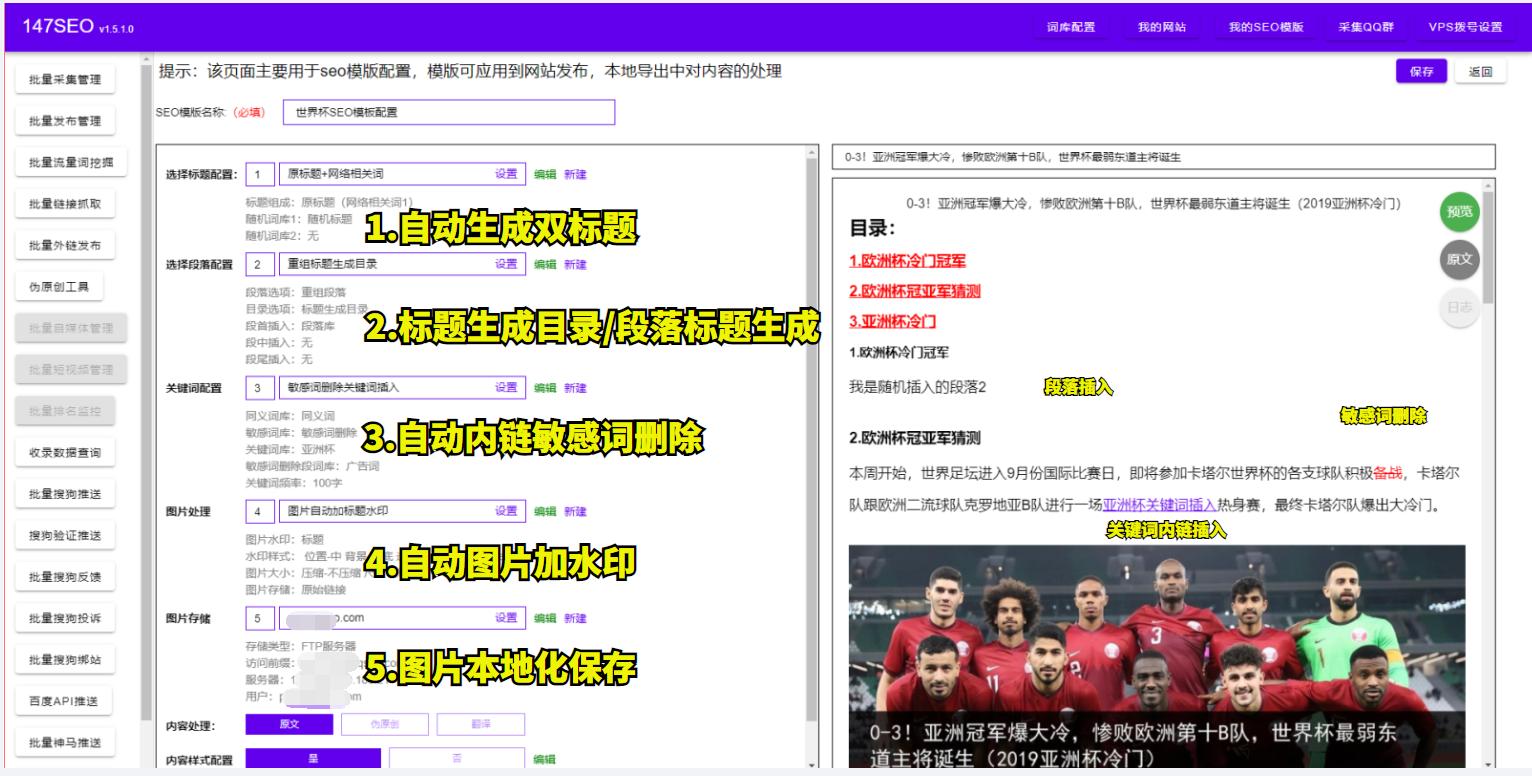

2.2 网页内容的抓取与解析过程

当爬虫访问一个URL时,它会发送HTTP请求获取网页内容。这个过程需要考虑很多实际因素:服务器响应速度、页面大小、资源加载情况。有时候遇到加载缓慢的页面,爬虫可能会选择暂时跳过,稍后重试。

获取到原始HTML后,解析阶段开始了。爬虫需要区分哪些是真正的内容,哪些是导航、广告或其他模板元素。现代爬虫运用了多种技术来识别主要内容区域,包括分析DOM结构、计算文本密度、检测重复模式等。

解析过程中,爬虫会特别关注某些关键元素:标题标签、元描述、正文内容、图片alt属性。这些信息不仅帮助理解页面主题,也影响后续的排名计算。记得有个做网站的朋友曾经困惑为什么某些页面没被正确索引,后来发现是页面结构过于复杂导致爬虫无法准确识别主要内容区块。

2.3 爬行频率与深度的控制策略

搜索引擎不会无限制地爬行整个网站。它们需要平衡资源消耗和抓取效果,这就涉及到精细的频率和深度控制。频率控制主要考虑网站更新速度、服务器承载能力和历史爬行效果。更新频繁的新闻网站可能每天被访问多次,而静态的企业网站可能几周才被访问一次。

深度控制则关注网站的层次结构。爬虫通常会设定一个最大深度值,避免陷入无限循环或过于深层的页面迷宫。重要页面往往位于较浅的层级,这其实符合用户体验原则 - 用户也不喜欢点击太多次才能找到需要的内容。

这些控制策略都是动态调整的。搜索引擎会持续监控网站的变化,根据内容更新频率、用户访问模式等因素智能调整爬行参数。一个健康的网站应该让爬虫能够高效地发现和抓取所有重要页面,而不是在无关紧要的角落浪费抓取配额。

搜索引擎爬行早已超越了单纯的技术范畴,它正在重塑我们与信息互动的方式。就像一位不知疲倦的数字图书管理员,它不仅要找到所有藏书,还要理解每本书的价值,预测读者未来的需求。这种能力正在各个领域展现出惊人的实用性。

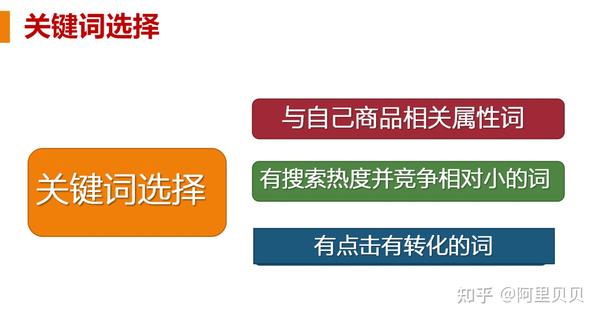

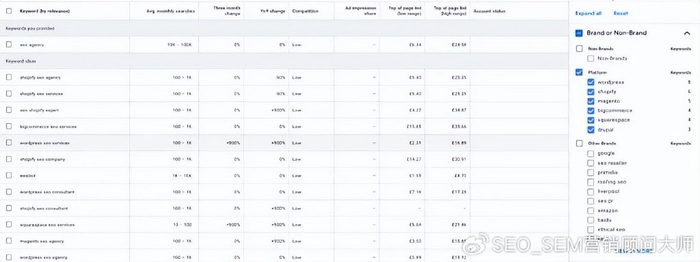

3.1 爬行技术在SEO优化中的重要性

网站能否被搜索引擎充分理解和收录,很大程度上取决于爬行效率。优质的爬行意味着搜索引擎能够完整抓取你的重要页面,这是所有SEO工作的基础前提。没有良好的爬行,再精彩的内容也无法进入搜索结果的舞台。

实践中,爬行优化涉及多个维度。网站结构需要清晰易懂,让爬虫能够顺畅地发现所有重要页面。内部链接的合理布局就像给爬虫绘制了一张详细的导览图。我记得有个电商网站重新设计了导航结构后,产品页面的收录率在两周内提升了40%,这直接带来了可观的流量增长。

服务器响应速度和稳定性同样关键。频繁的超时或错误响应会消耗宝贵的爬行配额,导致重要内容被遗漏。robots.txt的合理配置、XML网站地图的及时更新,这些看似基础的工作往往决定着爬行效果的好坏。

3.2 不同类型网站的爬行特点分析

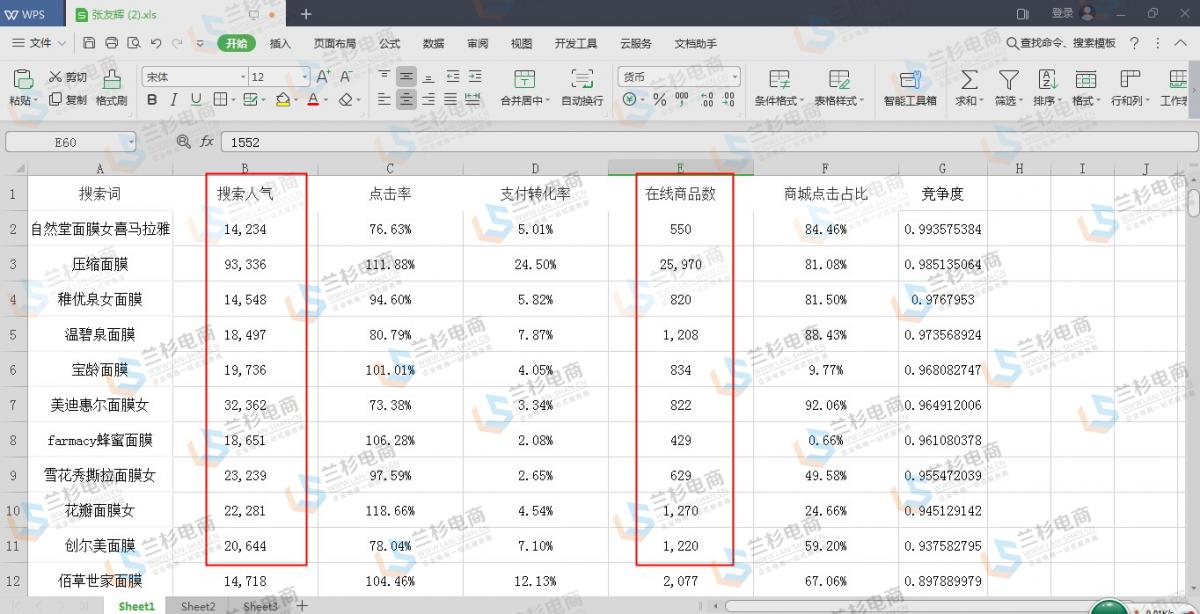

每个网站类型都面临着独特的爬行挑战。新闻资讯类网站需要极高的抓取频率,时效性内容必须在最短时间内被索引。它们的页面结构相对统一,但更新速度极快,这就要求爬虫能够快速识别新内容并调整访问节奏。

电商平台则是另一个极端。海量的产品页面、频繁的价格库存变化、复杂的筛选导航,这些因素都增加了爬行难度。优秀的电商网站会通过合理的URL结构设计和内部链接优化,确保所有有效产品页面都能被及时发现。

内容型网站如博客、知识库往往拥有深层次的页面结构。它们的价值在于内容的深度和专业性,但过于复杂的层级可能阻碍爬行效率。这类网站需要特别注意面包屑导航和相关推荐链接的设置,为爬虫提供清晰的路径指引。

企业官网虽然结构相对简单,但经常面临动态内容、JavaScript渲染等技术的挑战。现代爬虫虽然在这方面有所进步,但过于复杂的前端实现仍然可能影响内容的准确抓取。

3.3 人工智能时代下爬行技术的发展方向

人工智能正在重新定义搜索引擎爬行的边界。传统的规则驱动正在向智能决策转变,爬虫不再只是机械地执行预定任务,而是能够学习、适应甚至预测。这种进化让爬行过程变得更加智能和高效。

语义理解能力的提升是个明显趋势。爬虫不再仅仅分析页面上的文字,而是试图理解内容的真实含义和上下文关系。这让我想到最近测试的一个案例,同样主题的内容,用更自然语言表达的页面比关键词堆砌的页面获得了更好的理解效果。

个性化爬行可能成为下一个突破点。基于用户搜索行为和兴趣偏好,搜索引擎可以智能调整不同网站的爬行优先级和深度。对于特定领域的热门网站,爬虫会投入更多资源确保内容的及时更新。

实时性要求也在不断提高。随着5G和边缘计算的普及,用户期望获得近乎实时的信息更新。这对爬行技术提出了更高要求,需要建立更快速的发现和索引机制。未来的爬虫可能需要像新闻记者一样,具备敏锐的“新闻嗅觉”,能够第一时间捕捉到重要更新。

跨平台内容整合是另一个值得关注的方向。随着移动应用、社交媒体、物联网设备的普及,有价值的内容分散在各个封闭平台中。搜索引擎需要发展新的爬行技术来突破这些壁垒,为用户提供更完整的信息视图。